Даниил Кузнецов. Грезы о весне искусственного интеллекта

Изображение, сгенерированное ИИ по словам «грёзы о весне искусственного интеллекта» / ©Naked Science

Искусственный интеллект (ИИ) — эти два слова знают почти все, но мало кто может дать четкое определение и объяснить, что же это такое. Наши представления об ИИ сформированы скорее голливудским кинематографом, чем реальным пониманием стоящих за этим словом технологий. Кино, как и любое искусство, всегда работает со своим зрителем через эмоции. И самая продаваемая из них — страх.

Компьютер с ИИ HAL 9000 в «Космической одиссее 2001 года» захватывает управление межпланетным кораблем. Киборг Т-800 в «Терминаторе» отправляется в прошлое убить Сару Коннор. Совсем недавние примеры — нейроимплантат подчиняет сознание своего носителя в фильме «Апгрейд». Гиноид Ава легко манипулирует приглашенным для проведения обратного теста Тьюринга программистом, убивает своего создателя и сбегает на волю в фильме «Из машины». Примеров не перечесть. Однако реальность предельно далека от кинематографических образов.

Кадры из фильма «Космическая одиссея 2001 года» / ©Giphy

Человечество прошло долгий путь из 80 лет поисков, ошибок и тупиков, каждый из которых заканчивался «зимой искусственного интеллекта» — разочарованием в возможностях и потенциале этой технологии. Но с начала 2010-х мир вновь переживает «потепление» в области ИИ. Поэтому пока в кинотеатрах пытаются напугать обывателя — крупные корпорации и правительства ведущих стран вкладывают миллиарды в развитие ИИ, так как прямо сейчас он меняет всё — от научных исследований до повседневного быта.

Впрочем, даже самые передовые современные разработки до сих пор далеки по возможностям от любой фантазии режиссеров и сценаристов. Как обычно, представления о будущем могут совпасть в деталях, но никогда в главном. Давайте разберемся, что такое искусственный интеллект, и кратко проследим за основными вехами в истории его развития.

Изобретая понятия

Американский математик Джон Маккарти (1927-2011) впервые заинтересовался компьютерами в 1948 году, начав посещать семинар «Церебральные механизмы поведения», на котором в том числе обсуждалось, могут ли компьютеры начать мыслить как люди. Эта тема так увлекла его, что гораздо позже — летом 1956 года — он организовал десятинедельный семинар в Дартмутском колледже (частный исследовательский университет в штате Нью-Гэмпшир, США) на деньги фонда Рокфеллера.

В грантовой заявке Маккарти сформулировал цели семинара:

(Наше) исследование будет проводиться на основе предположения, что каждый аспект обучения или любая другая особенность (человеческого) интеллекта потенциально может быть настолько точно описана (математически), что станет возможно создать вычислительное устройство для его моделирования. (Мы) попытаемся найти способ, как заставить компьютеры использовать (естественный человеческий) язык, формировать абстракции и понятия, решать разнообразные проблемы, которые сейчас способны решить только люди, а также самосовершенствоваться. Мы считаем, что в одной или нескольких из этих проблем можно добиться значительного прогресса, если тщательно отобранная группа ученых будет работать над ней вместе в течение лета.

Собранная Маккарти команда действительно впечатляла. Там был создатель теории информации Клод Шеннон, будущая звезда математических оснований искусственного интеллекта и создатель теории фреймов Марвин Минский, когнитивный психолог Аллен Ньюэлл, разработавший впоследствии программу «Логик-теоретик», чьи модификации научились играть в шахматы и решать головоломки, и многие-многие другие талантливые люди.

Вождение в пробке с автопилотом Tesla, контролирующим расстояние до других автомобилей на дороге и центрирующим транспортное средство на полосе движения. Автомобиль представляет собой Model X 75D 2017 года выпуска с темным салоном / ©Wikimedia

Как положено настоящим ученым, Джон Маккарти с коллегами начали с определения понятий. И первое звучало так: «Искусственный интеллект — наука и инженерная деятельность, направленная на создание умных (intelligent) машин». Считается, что это первое в истории появление термина «искусственный интеллект». Позже название научной дисциплины, как это нередко бывает, перенесли и на обозначение объекта ее изучения и конструирования — сами «умные машины», реализованные как физически, так и в виде алгоритмов.

Более современный вариант определения может звучать иначе. Например, искусственный интеллект — одна из отраслей компьютерных наук, чьей задачей является обеспечение разумных рассуждений и действий с помощью вычислительных систем и иных искусственных устройств. При этом технологии, создаваемые на основе полученных внутри этой отрасли знаний, относятся к информационным технологиям.

Более современный вариант определения может звучать иначе. Например, искусственный интеллект — одна из отраслей компьютерных наук, чьей задачей является обеспечение разумных рассуждений и действий с помощью вычислительных систем и иных искусственных устройств. При этом технологии, создаваемые на основе полученных внутри этой отрасли знаний, относятся к информационным технологиям.

Ну а если говорить совсем просто, то искусственный интеллект — это область науки и технологий, которая занимается автоматизацией решения интеллектуальных задач. Если существует какая-то задача, которую люди решают при помощи своего интеллекта, то ученые и инженеры могут создать искусственную систему, которая подменит человека в ее решении. Это и будет система искусственного интеллекта.

Однако любой человек может решать множество интеллектуальных задач, например вести автомобиль, играть в шахматы, обсуждать по телефону планы на день и т. д. Причем иногда делать это все одновременно. А вот компьютеры пока на это не способны. Поэтому считается, что у нас созданы только системы слабого (weak) или узкого (narrow), либо прикладного (applied) искусственного интеллекта.

Все они способны выполнять только одну интеллектуальную задачу — управлять беспилотным автомобилем на улицах города или в совершенстве играть в шахматы. И даже если программа обыгрывает в шахматы чемпиона мира, она не способна вести автомобиль. А вот люди легко переключаются с одной задачи на другую и могут овладевать новыми навыками всю жизнь.

Систем слабого искусственного интеллекта — бессчетное количество. По сути, почти все инженеры и ученые заняты именно их развитием. Тем не менее основная цель отрасли — создание сильного (strong) или общего (general) искусственного интеллекта. Здесь уже не все так просто, и трудно сформулировать единое, удовлетворяющее всех определение. Связано это как с историей понятия, так и со сложностями в понимании человеческого и интеллекта и его возможностей.

Дело в том, что понятие сильного искусственного интеллекта впервые предложил философ Джон Сёрль наряду с концепцией «китайской комнаты». Вкратце она звучит так: если в закрытую комнату поместить человека, знающего китайский язык, а потом через специальный люк передавать ему вопросы, написанные по-китайски, то он будет писать ответы также на китайском исходя из понимания этого языка. Но что будет, продолжает мысленный эксперимент Сёрль, если в эту же комнату посадить другого человека, который не знает китайского, но при этом снабдить его исчерпывающей системой правил, позволяющей в ответ на получение одних последовательностей иероглифов, формировать другие?

Если система правил достаточно обширна, то не знающий китайского человек будет давать вполне осмысленные ответы на вопросы, даже не понимая их сути. Иными словами, он будет имитировать понимание китайского языка, не обладая им в действительности. Отсюда проистекает и его понятие «сильный искусственный интеллект», обозначающий систему, которая «ведет себя так, как будто является разумной», дабы отличить ее от системы, которая «на самом деле разумна».

Впрочем, сейчас оригинальную трактовку понятия «сильный искусственный интеллект» можно найти только в книгах по философии. А, например, компания IBM дает иное определение:

Сильный ИИ, также известный как общий искусственный интеллект (Artificial General Intelligence, AGI) — это теоретическое описание определенной формы ИИ, обладающей интеллектом, равным человеческому, самосознанием, а также способностью решать широкий круг интеллектуальных задач, учиться и планировать будущие действия.

Проще всего пояснить это определение на примере «Кофейного теста», предложенного сооснователем Apple Inc. и создателем первых персональных компьютеров этой компании Стивеном Возняком. Он достаточно прост, но до сих пор непреодолим ни для одной системы.

Такое изображение сгенерировал ИИ в ответ на запрос редакции Naked Science «кофе, который приготовил ИИ» / ©Naked Science

Суть «Кофейного теста» в том, чтобы проверить, насколько ИИ может полноценно взаимодействовать с человеком и реальным физическим окружением, а также успешно ориентироваться в новой обстановке без предварительного обучения. Для этого робот под управлением ИИ должен уметь в любой случайно взятой кухне, где он раньше не был и план которой не загружен в его систему, найти кофе, кофеварку или кофемашину — и приготовить напиток.

Множество кухонь здесь — широкий диапазон незнакомых сред, про которые ИИ ничего не знает. Цель — приготовление напитка. Ограничение — наличие или отсутствие средств достижения цели. Ведь иногда признать, что задачу невозможно решить — гораздо большее свидетельство интеллекта, чем бесплодные повторы.

Интересно, что ряд российских специалистов предполагает — создать общий ИИ будет невозможно, если роботы и алгоритмы не будут взаимодействовать с физической средой, как люди в ходе своего онтогенетического развития. Качественный прорыв возникнет именно с переходом в реальную действительность.

Многие ученые, такие как Марвин Минский, или предприниматели вроде Илона Маска, предсказывали, что общий ИИ будет создан в ближайшие десятилетия. Другие, наоборот, и сейчас считают, что его вовсе невозможно создать. Максимальным достижением будет разработка элементов сильного ИИ или узкого общего ИИ (narrow AGI), то есть систем, достигающих выдающихся результатов в одном типе задач и умеющих решать другие, но существенно ниже средних человеческих возможностей.

В круге третьем

Официальную историю ИИ обычно начинают за полтора десятка лет до появления самого понятия — с 1940-х годов. А вот предысторию можно провести с античных времен — автоматов Герона Александрийского и антикитерского механизма — механического устройства для расчета движения небесных тел. Однако все эти достижения скорее можно отнести к ранним этапам развития автоматики и вычислительной техники, но никак не к созданию машин, способных заменить человека в решении интеллектуальных задач.

Антикитерский механизм / ©Wikimedia

Вероятно, отсчет справедливо начинать с логической машины Раймонда Луллия (1235-1315). Луллий долго служил поэтом при арагонском короле, но затем сменил придворную жизнь на стезю монаха. В 1272 году во время религиозного экстаза его посетило божественное видение — особое устройство, с помощью которого можно из конечного числа общих понятий вывести все истины мира.

Свою машину Луллий описал в трактате «Великое искусство» (Ars Magna). По сути она представляла собой набор концентрических кругов, вращение которых позволяло получать различные сочетания символов и первичных понятий, главным образом богословских.

Наиболее простая вариация машины состояла из трех кругов. В первом содержался ряд латинских букв, во втором — понятия («сила», «доброта», «мудрость»), в третьем — свойства («сильный», «добрый», «мудрый»). А посередине между кругами располагался звездообразный граф, соединяющий все сектора кругов. В своем самом сложном варианте устройство содержало 14 кругов и давало астрономическое количество комбинаций.

Ars Magna / ©Wikimedia

Идеи Луллия впоследствии оказали серьезное влияние на философа и математика Готфрида Вильгельма Лейбница:

«В философии мною найдено средство достичь того же, что сделали Декарт и другие для арифметики и геометрии с помощью алгебры и анализа… посредством комбинаторики… указан путь, на котором все существующие составные понятия могут быть разложены на небольшое число простых понятий, являющихся как бы их алфавитом, и посредством правильного метода из комбинаций букв такого алфавита могут быть со временем получены все вещи вместе с их теоретическими доказательствами».

Увы, но в итоге создать «алфавит человеческой мысли» и привести все философские умозаключения к строгой форме Лейбницу не удалось. Зато в попытках его изобретения он придумал всем известную двоичную систему из 0 и 1. Сейчас она лежит в основе любых вычислительных устройств и кодирует как числовые данные, так и логические операции.

Параллельно труды Луллия заинтересовали и российских мыслителей. В конце XVII — начале XVIII веков Ars Magna на русский язык перевел поэт и философ Андрей Белобоцкий. В допетровской Руси большое распространение получили две его рукописи «Великая наука Раймунда Луллия» и «Краткая наука Раймунда Луллия».

Отец перфокарт

Судя по всему, с этими книгами был хорошо знаком Семен Корсаков (1787-1853), изобретатель первых российских интеллектуальных машин. Корсаков придумал и подробно описал пять схожих друг с другом устройств, предназначенных для поиска и классификации информации. Самое простое из них — «прямолинейный гомеоскоп с неподвижными частями». В нем использовалась перфорированная таблица, по столбцам которой перемещалась деревянная планка с булавками-шипами разной высоты. По совпадению отверстий в таблице с выступающими шипами определялся нужный столбец. Сходным образом работали и другие предложенные им машины, несколько более сложные: прямолинейный гомеоскоп с подвижными частями, плоский гомеоскоп, идеоскоп и компаратор.

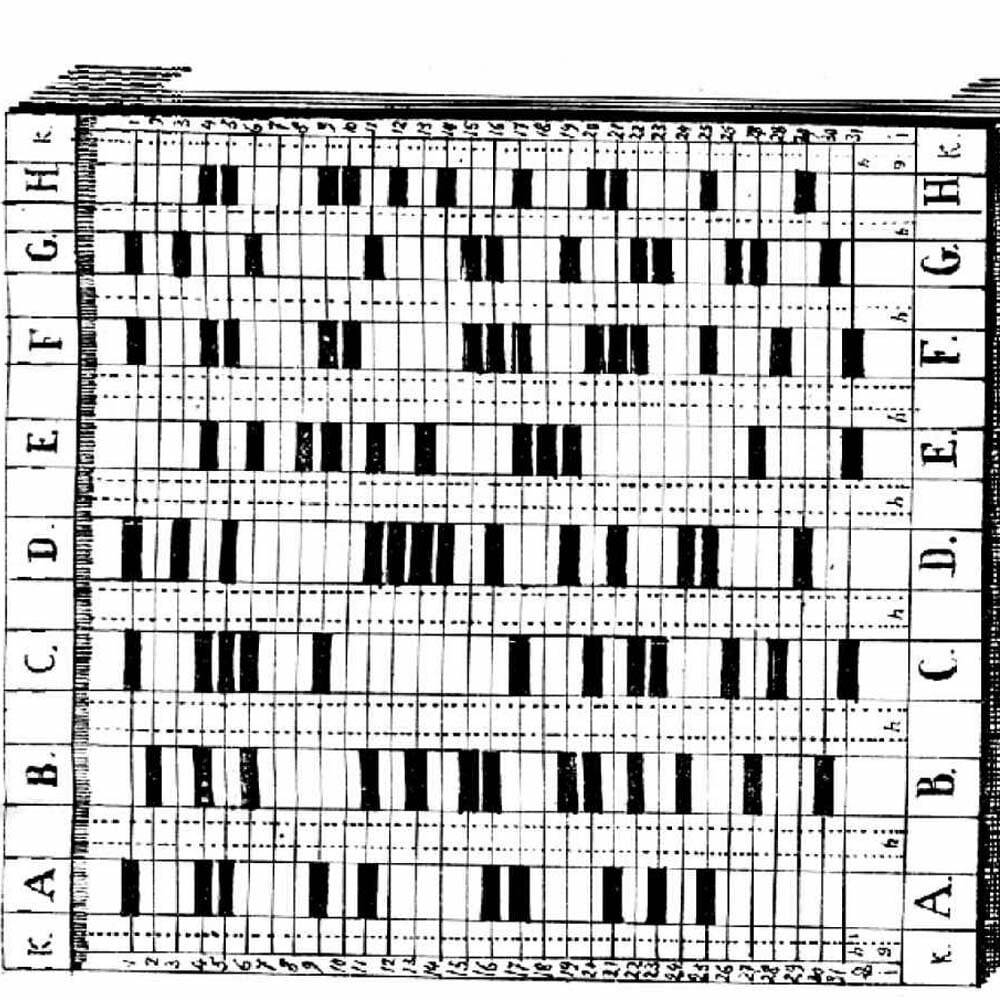

Перфокарта для интеллектуальных машин Семена Николаевича Корсакова / ©Wikimedia

Объясняя принцип работы гомеоскопа, Корсаков приводил пример из медицинской диагностики: столбцы таблицы содержат симптомы болезней, а шипы на планке врач выставляет в соответствии с симптомами, которые наблюдаются у пациента. Планка движется вдоль столбцов, пока не упрется в нужный, и врачу остается лишь выбрать подходящее лекарство. «Число деталей, которые учитывает устройство, может достигать многих сотен», — добавляет Корсаков. По сути, это первая в мире экспертная система для поддержки принятия решений врачом!

Спустя почти полтора века, в 1980-х, на публикации Корсакова наткнулся крупный советский математик и кибернетик Гелий Поваров, живо интересовавшийся историей и предысторией развития этих наук в нашей стране. Поваров популяризировал его идеи и сделал Корсакова одним из основоположников отечественной кибернетики, а также закрепил за ним весомое мировое достижение — первое в истории информатики использование перфокарт.

Ранние идеи

С кибернетики, собственно, и начинается официальная история искусственного интеллекта. В первоначальном изводе кибернетика не столько наука, сколько метатеория, описывающая, как информация создается и обрабатывается в рамках управления любыми сложными системами от биологического организма до транснациональной компании.

В итоге кибернетика быстро распалась, дав плодотворную почву для возникновения компьютерных наук, ряда направлений в биологии, математике, менеджменте, инжиниринге и так далее. А что касается искусственного интеллекта, то в лоне кибернетики зародилась самая длительная и успешная, хотя и пережившая несколько кризисов, программа исследований искусственных нейронных сетей.

С точки зрения специалиста из Исследовательского центра прикладных систем искусственного интеллекта МФТИ — PhysTech AI Михаила Бурцева, существует три подхода к конструированию умных машин, способных выполнять интеллектуальные задачи.

1. Обучение нейросетей и глубинное обучение. Основано на физическом и программном моделировании отдельных нейронов, нервных сетей и мозга животных и человека.

2. Символьный искусственный интеллект. Основан на моделировании способов рассуждения и логических выводов людей.

3. Эволюционное программирование и генетические алгоритмы. Основаны на моделировании эволюционных механизмов, в условиях которых алгоритмам для достижения лучших решений приходится мутировать и выживать, испытывая жесткое давление естественного отбора.

Первые два подхода активно развиваются начиная с 1940-1950-х годов. Тогда как эволюционное направление и ряд других появились с 1960-х по 1990-е годы и сейчас немного ушли в тень.

Взлет и падение нейросетей

В начале 1940-х годов в Университете Чикаго случайно встретились два абсолютно непохожих друг на друга человека, чтобы совершить фундаментальное открытие, заложившее траекторию развития искусственного интеллекта на десятилетия вперед. Уоррену Мак-Каллоку было 42, состоявшийся профессор, сын бизнесмена, увлеченный поиском «психона» — элементарной единицы нервной деятельности. А Уолтеру Питтсу едва стукнуло 18 — вундеркинд, написавший в 13 лет письмо Бертрану Расселу, автодидакт, не получивший формального образования, выходец из бедной неблагополучной семьи в Детройте.

Тем не менее их сотрудничество оказалось на редкость плодотворным. В 1943 году они предложили модель «формального нейрона», работающего по законам математической логики.

У большинства живых нервных клеток всегда есть множество маленьких отростков-дендритов (по ним сигналы идут в клетку извне), тело и один большой отросток-аксон (через него сигнал выходит из клетки). Работает вся эта машинерия по принципу «всё или ничего» — если входящие импульсы не превышают некого порога, то нейрон не дает ответа вообще, а если превосходит порог, то генерируется максимально возможный ответ.

Так себе представляет нейрон ИИ (в ответ на редакционный запрос «нейрон») / ©Naked Science

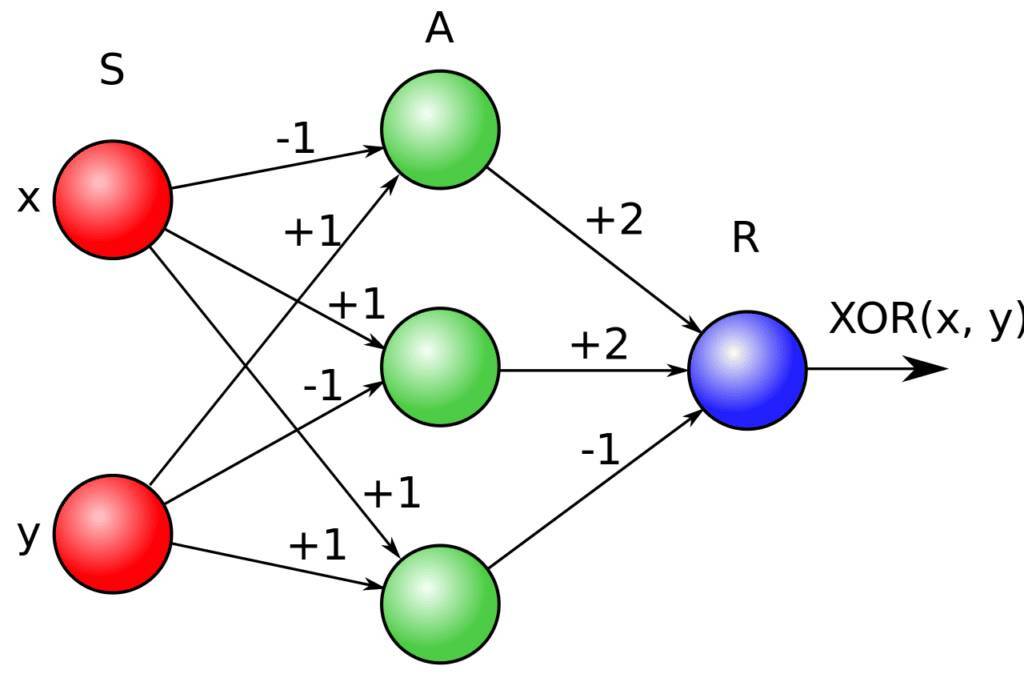

«Формальный нейрон» также представлял собой пороговый элемент, работающий по принципу «всё или ничего» в строго фиксированные моменты времени. У него имелось конечное число входов и один выход. Входы делились на возбуждающие (+1), тормозящие (–1) и запрещающие. Последние могли блокировать сигналы с каких-либо других входов. Если в определенный момент алгебраическая сумма воздействий, поступивших на нейрон по входам, достигала или превышала порог (0), то на выходе нейрона появлялся сигнал.

Их вышедшая в 1943 году статья в журнале Bulletin of Mathematical Biophysics под названием «Логическое исчисление идей, относящихся к нервной активности» вызвала фурор и спустя 13 лет была переведена и опубликована в СССР, где моделирование нейронов вызвало большой интерес. Российский кибернетик Виктор Варшавский предложил свою обобщенную модель порогового нейрона. Группа под руководством Никиты Позина создала в Институте проблем управления АН электронную модель нейрона. А коллектив, возглавляемый Николаем Амосовым, последовательно разрабатывал идею сетей из «формальных нейронов» для создания внутри вычислительных машин своеобразных «информационных внутренних моделей» внешнего мира. К сожалению, из-за отсутствия переводов на иностранные языки и слабых внешних контактов почти все эти работы остались неизвестны мировой науке и инженерии.

Наибольшее влияние идея Мак-Каллока и Питтса, что «формальные нейроны» с бинарными входами выполняют логические вычисления, поэтому мозг можно уподобить машине логического вывода, оказала на психолога Фрэнка Розенблатта из Корнельского университета. Он работал в лаборатории аэронавтики, но при этом всю жизнь мечтал заниматься поиском экзопланет, для чего ему был нужен автоматический инструмент распознавания и классификации изображений. И он его изобрел.

В истории науки и технологий Розенблатт навсегда остался отцом перцептрона — прямого предшественника современных систем глубокого обучения. По сути, перцептрон — это нейронная сеть из одного модифицированного нейрона Мак-Каллока и Питтса. Однако модификация эта очень существенная — здесь добавляются веса связи входного сигнала с блоком выхода, или, проще говоря, меры влияния каждого входа нейрона на значение, получаемое на выходе.

Веса позволяют перцептронам обучаться самостоятельно. Происходит это так: например, мы хотим, чтобы перцептрон научился определять букву А и указываем ожидаемые выходы: +1 для А и -1 для любой другой буквы алфавита. После на вход перцептрона подаем изображения букв. При ошибках веса автоматически корректируются (например, если выдает +1, когда должно быть -1 и наоборот). Если же ответ верный, то в него не вносится никаких изменений. Постепенно перцептрон находит необходимый набор весов и перестает ошибаться, четко опознавая букву А.

В 1957 году Розенблатт доказал теорему сходимости перцептрона. Важный вклад в обобщение принципов работы перцептронов внес и российский математик Владимир Вапник, создавший «метод опорных векторов», впоследствии нашедший широкое применение в машинном обучении. С его помощью можно автоматически вычислить плоскость, максимально эффективно разделяющую две группы точек в декартовом пространстве (скажем, фото собак и кошек), то есть также решающую задачу классификации (в данном случае бинарной).

Решение элементарным перцептроном «задачи XOR». Порог всех элементов = 0 / ©Сергей Яковлев, Alex Krainov (Wikimedia)

Несмотря на все успехи, из-за ограниченных возможностей электроники и вычислительной техники того времени перцептроны не получили большого распространения в решении прикладных задач. А затем им нанесли сокрушительный удар математики Марвин Минский и Сеймур Пейперт, показавшие в своей книге «Перцептроны», что создание многослойных классификаторов такого типа, скорее всего, невозможно. В тот момент их, как потом оказалось ошибочные, соображения приняли на веру. До середины 1980-х нейросети были забыты.

Логика, эвристики и знания

Все началось с желания написать программу для игры в шахматы. В 1954 году будущие участники Дартмурского семинара Аллен Ньюэлл и Герберт Саймон с присоединившимся к ним Джоном Клиффордом Шоу принялись за дело. В работе они исходили из ряда предпосылок. Во-первых, программа должна использовать эмпирические методы и правила, выведенные на основе анализа способа решения задач человеком. Люди в процессе размышлений осуществляют когнитивную деятельность. Она заключается в операциях над символьными репрезентациями предметов окружающего мира. Таким образом, физическую вычислительную систему необходимо снабдить знаниями о мире и способами обращения с ними. Здесь начинается история символьного ИИ и эвристического программирования.

К исследованиям тут же привлекли психологов. Они изучали стили игры успешных шахматистов и способы решения разнообразных проблем людьми. Затем команда создала собственный язык программирования Information Processing Language (IPL), вероятно первый, в котором данные были представлены в виде связных списков символов. На нем последовательно было написано три программы: «Логик-теоретик» в 1956 году, «Универсальный решатель проблем» в 1957-м и собственно шахматная программа NSS в 1958-м.

«Логик-теоретик» умел доказывать теоремы из элементарной математики. В машину водились списки переменных, которые могли объединяться в выражения при помощи логических связок — «И» (конъюнкция), «ИЛИ» (дизъюнкция), «ЕСЛИ… ТО…» (импликация). Далее задавались аксиомы и три правила вывода: подстановка, замена, разделение.

Под доказательством в итоге понимались последовательности выражений, где каждое выведено из предыдущих, причем начинается все от аксиом и уже известных теорем, а ведет к желаемому выражению. Такой подход получил название эвристического программирования, так как, с одной стороны, он воссоздает реальные человеческие действия с символами, а с другой — отсекает множество возможных последовательностей и выражений на основании заданных правил.

Как итог «Универсальный решатель проблем» научился справляться с рядом головоломок, находить неопределенные интегралы, решать алгебраические задачи. А NSS вполне сносно играла в шахматы. Для этого, правда, пришлось в управляющий алгоритм добавить описания целей и оценки текущей и целевой ситуаций, а также их расхождения.

В СССР эвристическое программирование тоже привлекло внимание ученых. В начале психологов, исследующих мышление, таких как Вениамин Пушкин, у которого эвристики стали операционализированным и экспериментально изучаемым понятием в опытах с людьми. И лишь затем, несколько позже — кибернетиков и логиков. Совместно с Пушкиным российский специалист по ИИ Дмитрий Поспелов провел ряд исследований ситуационного управления — принятия решений в конкретных ситуациях с учетом множества вариантов действий. Ну а логик Сергей Маслов впервые предложил метод автоматического поиска доказательств теорем в исчислении предикатов.

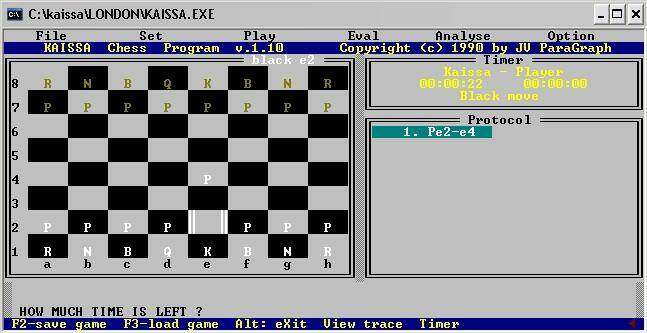

Программа по игре в шахматы «Каисса» / ©Alexandr Shevtsov, chess.com

Параллельно разработкой шахматных программ занимался гроссмейстер, VI чемпион мира в истории шахмат Михаил Ботвинник. Свой «Пионер» он совместно с командой программистов создавал с конца 1950-х до 1990 года. Впрочем, без большого успеха. Чего нельзя сказать о программе «Каисса», созданной в Институте проблем управления АН СССР. В 1974 году она выиграла чемпионат мира среди других шахматных программ.

ЛИСП, ПРОЛОГ и российский РЕФАЛ

IPL лег в основу другого знаменитого языка, используемого для систем ИИ. В 1958 году автор термина «искусственный интеллект» Джон Маккарти представил заинтересованной публике язык ЛИСП (LISP — LISt Processing). Как и все другие языки, ориентированные на решение интеллектуальных задач, ЛИСП предназначался для обработки не числовых, а символьных данных, организованных в списки, так же как и сам исполняемый код программ. Но самое главное — в нем на уровне синтаксиса были реализованы эвристики, например редукции, то есть разбиения любой сложной задачи на простые. Для определения функций могли использоваться выражения, а система записи предусматривала использование большого количества скобок, из-за чего код часто оказывался трудночитаемым.

Другим специализированным языком для ИИ стал ПРОЛОГ (PROLOG — PROgramming LOGic), созданный в 1972 году как вершина направления логического программирования. Традиционный силлогизм «Все люди смертны. Сократ — человек. Следовательно Сократ смертен» в ПРОЛОГе превращался в «Для того чтобы доказать, что Сократ смертен, сделай подцелью доказательство, что Сократ — человек» — и синтаксически это выглядело так:

смертен (Сократ) :— человек (Сократ)

Подобные специализированные языки программирования для создания систем символьного ИИ разрабатывались и в нашей стране. Так, в 1966 году Валентин Турчин представил язык РЕФАЛ (РЕкурсивных Функций АЛгоритмический). На сегодня это старейший функциональный язык. Турчин предполагал, что он будет служить алгоритмическим метаязыком для описания семантики других языков, но по факту он оказался очень удобен для обработки символьной информации, а значит и решения интеллектуальных задач.

Эвристическое программирование с использованием логики и операций с символьной информацией процветали почти 20 лет. Однако к середине 1970-х всем специалистам стало ясно, что достигнут предел усложнения алгоритмов и улучшения эвристик. Принципиального прорыва можно не ждать. Требовалось дооснащать алгоритмы огромными базами знаний, а технологические возможности этого не позволяли. В совокупности с упадком перцептронов и других нейросетей это привело в 1970-х к первой «зиме искусственного интеллекта».

Как бы то ни было, эвристики не умерли и вполне эффективно развивались до середины 2000-х. Ограниченное применение они имеют и сейчас. А тот же язык ЛИСП используется, например, в продуктах Autodesk для инженеров.

Новый ренессанс нейросетей

Перцептроны Розенблатта достигли предела своих возможностей еще к началу 1960-х. Для решения более сложных задач, чем детекция отдельных букв, требовалось увеличить количество слоев в нейросети. Остро встал вопрос: как обучать такие системы и возможно ли это? Общее мнение ученых того времени, выраженное знаменитым Марвином Минским, — нет. В отрасли все почувствовали, что «зима близко» — исследования ИИ начали считать бесперспективными, финансирование резко рухнуло, тема не только вышла из моды, но и стала в определенной степени маргинальной.

Изображение, сгенерированное ИИ в ответ на запрос редакции «ренессанс нейросетей» / ©Naked Science

И здесь на выручку искусственному интеллекту вновь пришли психологи. Среди инженеров и естественников психология всегда имела статус псевдонауки, так почему бы им не подхватить отверженную тему, если в среде технической интеллигенции она утратила былой статус? Первая «весна искусственного интеллекта» в середине 1980-х годов связана с именем Дэвида Румельхарта, когнитивного и математического психолога из Калифорнийского университета Сан-Диего, и изобретением метода обратного распространения ошибки или градиентного спуска.

Забавно, но и в данном случае, если бы наука в СССР того времени была больше интегрирована в международную и велись публикации на английском языке или хотя бы систематические переводы советских работ за рубежом, то, возможно, революция нейросетей началась бы лет на десять раньше. Сегодня даже историкам вычислительной техники практически не известны имена Автандила Квиташвили, Генриха Отхмезури, Сергея Даяна и других, экспериментировавших в 1950-1970-е годы над многорядными перцептронами.

Дэвид Румельхарт / ©Rolf Kickuth (Wikimedia)

Кибернетик Алексей Ивахненко, используя метод группового учета аргументов, — фактически один из первых алгоритмов машинного обучения — еще в начале 1970-х обучал восьмислойные нейронные сети, правда созданные на основе иного типа «формальных нейронов». А в 1974 году будущий профессор МФТИ Александр Галушкин опубликовал монографию «Синтез многослойных систем распознавания образов», где описал системы распознавания, состоящие из линейно-пороговых элементов, организованных в виде сетей с разомкнутым контуром. В своей работе Галушкин переформулировал задачу обучения многослойных сетей и сетей с рекуррентными связями как задачу градиентного спуска.

И все же, увы, всемирный прорыв произошел только после публикации в журнале Nature статьи Learning representations by back-propagating errors за авторством Дэвида Румельхарта, Джеффри Хинтона и Рона Уильямса. В ней описывались многослойные нейросети и новый метод их обучения.

Итак, например, у нас есть нейросеть, состоящая из трех слоев нейронов: пять на входе, три в скрытом слое и один на выходе. Как мы помним, между нейронами есть связи и веса этих связей. При наличии нескольких слоев в сети веса выстраиваются в вектор значений или градиент.

Как и в случае с перцептронами, учитель задает значение на выходе. Если полученное в результате одной эпохи обучения значение на выходе не совпадает с заданным, то разница используется для обновления весов в связях выходного нейрона. А далее меняются веса связей в скрытых нейронах и входных на основе обратного распространения ошибки и исходя из того, как каждый вес влияет на эту ошибку.

По сути, Румельхарт и его коллеги придумали, как вычислить градиент каждого веса в сети начиная с выходного слоя, где известна ошибка, и вплоть до входного, слой за слоем. Как итог теперь нейронные сети можно было обучать решению сложных задач и тренировать на большом количестве данных. Возникло настоящее глубокое обучение.

1980-е годы породили новую волну оптимизма. Но прорывные открытия того времени, заложившие основы большинства современных моделей ИИ, в итоге не дали тех результатов, на которые все надеялись. Причин такого исхода было две: отсутствие данных для эффективного обучения и слабые вычислительные мощности. Модели обучались слишком медленно, долго и в итоге все равно не решали поставленных задач.

К 2000 году ажиотаж спал окончательно. Наступила вторая «зима искусственного интеллекта», закончившаяся лишь в 2010-х с появлением мощных графических процессоров (GPU), пригодных для высокопроизводительных параллельных вычислений, а также доступом к большим наборам данных вроде базы ImageNet c 15 млн изображений, разбитых на 22 тыс. категорий.

Кроме того, за «тихие годы» появилось немало новых подходов к конструированию нейросетей: свёрточные нейронные сети (Ян Лекун), сети с долгой краткосрочной памятью (Зеп Хохрайтер, Юрген Шмидхубер), порождающие состязательные сети, автоэнкодеры и многие другие. Состоялся грандиозный прорыв, благодаря которому в настоящий момент сложно найти место, где не используется ИИ — от рекомендательных сетей в онлайн-кинотеатре и опознания лиц в фотоаппарате смартфона до птицефабрик и операционных в больницах.

Великие державы искусственного интеллекта

В мире два лидера в области искусственного интеллекта — США и Китай. Эти державы удерживают первенство в числе научных публикаций об ИИ, количестве патентов, стартапов, созданных моделей и технологий. В условиях, когда «ИИ в мире стал вторым электричеством», Россия не имеет права далеко отпускать конкурирующие государства в новой технологической гонке. По сути, сейчас ситуация повторяет 1940-1950-е годы и 1950-1960-е, когда СССР и США соревновались сначала в атомной, а потом в космической гонках. Особенно остро встал вопрос с наличием собственных технологий ИИ, когда Россия попала под беспрецедентный в мировой истории гнёт санкций.

Отвечая на вызовы времени, российское правительство разработало Национальную стратегию развития искусственного интеллекта в стране. Запущен Национальный центр развития искусственного интеллекта при правительстве РФ. Активно реализуется федеральный проект «Искусственный интеллект», одним из мероприятий которого стало создание на базе ведущих научно-образовательных организаций шести исследовательских центров при ведущих вузах и институтах России (МФТИ, НИУ ВШЭ, Сколтех, Университет ИТМО, Иннополис, Институт системного программирования им. В.П. Иванникова РАН).

Изображение, сгенерированное OPENAI DALL-E Artificial Intelligence по запросу «бесконечный сервер» / ©Encik Tekateki, OPENAI DALLE2

Не отстают и крупнейшие российские компании, среди которых такие технологические лидеры как «Яндекс», «Сбер», МТС, VK. Так, командами «Сбера» были обучены большие генеративные модели ruGPT-3 и ruDALL-E, основанные на архитектуре трансформеров. Последняя, например, позволяет генерировать изображения на основе русскоязычных описаний. В ходе исследований «Сбером» также были созданы собственные бенчмарки для оценки качества работы мультимодальных алгоритмов для решения различных задач. «Яндекс», помимо прикладных технологий ИИ, интегрированных в поиск, не так давно выложил в открытый доступ самую большую языковую модель YaLM 100B (Yet another Language Model) и уже несколько лет тестирует собственные беспилотные автомобили.

Взаимодействие компаний с вузами, например, Исследовательского центра прикладных систем искусственного интеллекта МФТИ с рядом индустриальных партнеров и стартапов, позволяет создавать беспилотный транспорт (автомобильный и воздушный), автономных и управляемых голосом роботов с элементами сильного искусственного интеллекта, оснащенных также передовыми системами компьютерного зрения. Такое сочетание разных технологий дает возможность роботам выполнять сложные задачи в разнообразных, в том числе и незнакомых средах.

У России огромный потенциал стать третьей мировой державой искусственного интеллекта. Ограничение лишь одно — в отрасли огромная нехватка квалифицированных кадров. Государство и компании готовы бесплатно обучать молодёжь, в том числе девушек, желающих перейти в сферу STEM, и всех, кто готов сменить область деятельности и войти не просто в IT, а в самую передовую область информационных технологий — системы искусственного интеллекта.

Послесловие Н. Скрипкина

По мере развития нашей цивилизации человек постоянно что то теряет. Сначала он потерял физическую силу, потом уменьшился объём мозга и ухудшилась память. Но ему всё время удавалось выкручиваться. Физическую силу заменили орудия труда, письменность заменила память. И вот пришла пора терять интеллект. И тут уже ничего нельзя поделать. Или совершенствовать самого себя или уступать самовольно занятое место «царя природы». А так не хочется!

Другие публикации по теме: Денис Тулинов. Что мы можем извлечь из «черного ящика»?

Leave a reply

Для отправки комментария вам необходимо авторизоваться.